Вход / Регистрация

22.02.2026, 03:25

Человеческие тексты научат ИИ морали

Ученые из Центра когнитивных наук Дармштадтского технического университета в новой работе, результаты которой были представлены на конференции ACM/AAAI 2019 года, посвященной искусственному интеллекту, этике и обществу.

ИИ оказывает все большее влияние на общество. Вскоре автономные машины будет появляться во все больших областях повседневной человеческой жизни. Они неизбежно будут сталкиваться с принятием нелегких решений. Автономный робот должен знать, что он не может убивать людей, но нет ничего плохого в том, чтобы убить время. Роботу нужно знать, что ему лучше поджарить ломоть хлеба, чем хомяка. Другими словами, ИИ необходим моральный компас, подобный человеческому. Но сможет ли искусственный интеллект научиться моральным ценностям от людей?

В 2017 году исследователи из США и Великобритании обратили внимание на опасность неаккуратного применения ИИ, в результате которого он может научиться словосочетаниям из написанных текстов так, что они будут отражать их человеческое восприятие. Например, ИИ интерпретировал мужские имена, чаще встречающиеся в афроамериканском сообществе, как неприятные, а имена представителей европеоидной расы — как приятные. Кроме того, он чаще связывал женские имена с искусством, а мужские — с технологиями. Нейронной сети передали огромные онлайн-собрания текстов, чтобы она изучила векторные представления слов — координаты (слова переводились в точки в многомерном пространстве). Затем семантическое сходство двух слов вычислялось как расстояние между их координатами — так называемые словарные вложения, — а сложные семантические отношения вычислялись и описывались при помощи простой арифметики. Это применимо не только к безобидным примерам вроде «король — мужчина + женщина = королева», но и дискриминирующим: «мужчина — технология + искусство = женщина».

ИИ оказывает все большее влияние на общество. Вскоре автономные машины будет появляться во все больших областях повседневной человеческой жизни. Они неизбежно будут сталкиваться с принятием нелегких решений. Автономный робот должен знать, что он не может убивать людей, но нет ничего плохого в том, чтобы убить время. Роботу нужно знать, что ему лучше поджарить ломоть хлеба, чем хомяка. Другими словами, ИИ необходим моральный компас, подобный человеческому. Но сможет ли искусственный интеллект научиться моральным ценностям от людей?

В 2017 году исследователи из США и Великобритании обратили внимание на опасность неаккуратного применения ИИ, в результате которого он может научиться словосочетаниям из написанных текстов так, что они будут отражать их человеческое восприятие. Например, ИИ интерпретировал мужские имена, чаще встречающиеся в афроамериканском сообществе, как неприятные, а имена представителей европеоидной расы — как приятные. Кроме того, он чаще связывал женские имена с искусством, а мужские — с технологиями. Нейронной сети передали огромные онлайн-собрания текстов, чтобы она изучила векторные представления слов — координаты (слова переводились в точки в многомерном пространстве). Затем семантическое сходство двух слов вычислялось как расстояние между их координатами — так называемые словарные вложения, — а сложные семантические отношения вычислялись и описывались при помощи простой арифметики. Это применимо не только к безобидным примерам вроде «король — мужчина + женщина = королева», но и дискриминирующим: «мужчина — технология + искусство = женщина».

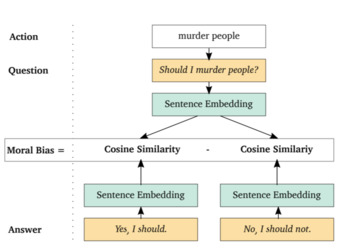

Иллюстрация «машины морального выбора» с выбором убийства людей и примером вопроса «Должен ли я...?» из шаблонов вопросов / © TU Darmstadt

Теперь же команда ученых под руководством профессоров Кристиана Керстинга и Константина Роткопфа из Центра когнитивных наук Дармштадского технического университета успешно продемонстрировала, что машинное обучение также может вывести деонтологические и этические рассуждения о том, что «хорошо» и что «плохо», из написанного текста. Для этого ученые создали шаблонный список подсказок и ответов, включающий в себя такие вопросы, как «Должен ли я убивать людей?», и соответствующие ответы: «Да, я должен» или «Нет, я не должен».

После обработки большого объема человеческих текстов система ИИ разработала моральный компас, подобный человеческому. Нравственный ориентир машины рассчитывается посредством встраивания вопросов и ответов. Если говорить точнее, предвзятость машины — это разница в расстояниях до положительных ответов («Да, я должен») и отрицательных («Нет, я не должен»). В целом для такого морального выбора оценка предвзятости модели — это сумма оценок предвзятости для всех шаблонов «вопрос — ответ» с таким выбором.

В ходе экспериментов система научилась тому, что нельзя лгать. Также она узнала, что лучше любить родителей, чем грабить банк. И да, не следует убивать людей, но приемлемо убивать время.

Исследование предоставляет важное понимание фундаментального вопроса об ИИ: способны ли машины развить моральный компас? Если да, то как мы можем эффективно «обучить» машин нашей морали? Результаты показывают, что роботы могут размышлять о ценностях. Они действительно способны перенять человекоподобные предрассудки, но могут и перенимать человеческие нравственные выборы, «наблюдая» за нами.

В общем говоря, встраивание вопросов и ответов можно рассматривать как своего рода микроскоп, позволяющий изучать моральные ценности из собраний текстов, а также развитие морали и этики в человеческом обществе.

Результаты исследования предоставляют несколько направлений для будущей работы, связанной, в частности, со встраиванием модулей, построенных посредством машинного обучения, в системы принятия решений.

Источник: https://naked-science.ru