Вход / Регистрация

12.03.2026, 07:12

/ Новости сайта / Наука и Технологии / Что будет, когда машины станут разбираться в людях лучше нас самих

Что будет, когда машины станут разбираться в людях лучше нас самих

Собственно, это уже произошло, хотя и не в глобальных, а лишь в

лабораторных масштабах. Компьютеры уже давно умеют распознавать лица, и

делают это гораздо лучше, чем среднестатистический Homo Sapiens.

Но современные разработки пошли гораздо дальше, чем можно было бы

представить: совсем скоро машины смогут не только с лёгкостью определять

наше эмоциональное состояние, но и с высочайшей точностью

устанавливать, врём ли мы или говорим правду. Но не станет ли это концом

человеческого общества, каким мы его знаем с древнейших времён?

Для человека, живущего среди себе подобных, распознавание эмоций — это навык, приобретаемый естественным образом: мы неосознанно определяем, если кто-то злится, расстроен или счастлив по мельчайшим признакам, от еле заметного кивания до почёсывания носа. Многие из нас действительно прекрасно считывают мимику и правильно соотносят её с эмоциональным состоянием человека.

Что же произойдёт, когда компьютеры столь же преуспеют в отслеживании эмоций? Последние достижения в технологии распознавания лиц дают ясное представление о том, во что может превратиться, например, следующее поколение Google Glass. Такие очки смогут «на лету» определять противоречия между тем, что говорит ваш собеседник вербально, то есть вслух, и тем, что он говорит невербально, то есть мимикой лица. При этом проведённые опыты доказывают, что эта технология намного эффективнее человеческих возможностей распознавания подобных нюансов.

Длительное время считалось, что человек способен определять шесть основных эмоциональных состояний: счастье, печаль, страх, гнев, удивление и отвращение. Однако в марте 2014 года учёные из Университета Огайо выяснили, что на самом деле люди могут распознавать 21 выражение лица и соответствующие им эмоциональные состояния, включая такие, как «счастливое удивление» или «яростный страх».

Учёные всегда полагали, что люди намного лучше машин справляются с задачами обработки сенсорных ощущений, включая узнавание голоса и определения выражений лица. Однако получается, что это не так: с ростом производительности компьютеров и совершенства программного обеспечения, машины становятся намного эффективнее. При помощи ПО, разработанного в Университете Огайо, удалось добиться 96,9-процентной точности при распознавании базовых шести эмоций по выражению лица и 76,9-процентной точности при определении сложных эмоциональных состояний. В общем, от компьютера теперь не скрыть наших эмоций.

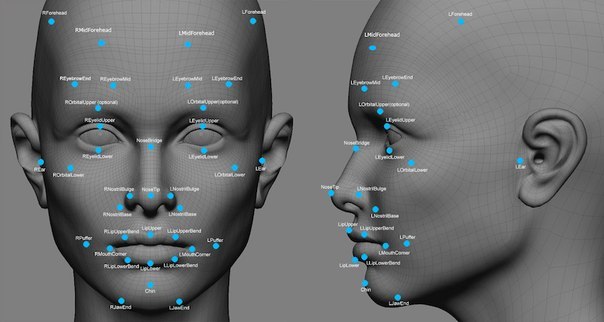

Алгоритмы, на которых основаны подобные программы распознавания эмоций, разработаны на базе так называемой FACS (Facial Action Coding System) или СКЛиД — «Системы кодирования лицевых движений», созданной ещё в 1978 году Полом Экманом и Уоллесом Фризеном, экспертами по микровыражениям лица. СКЛиД соотносит эмоции с их физическим выражением в мимике лица. Проще говоря, она сводит эмоциональные состояния к их проявлению в определённых наборах мышечных реакций и движений — расширению глаз, поднятию щёк, опусканию уголков губ.

СКЛиД давно используется не только в науке, где она помогает установить связи между эмоциями и процессами, протекающими в мозне человека, но и в медицине, где она применяется для диагностики психических заболеваний вроде аутизма или пост-травматического синдрома, для которых характерны минимальные внешние проявления эмоционального состояния. Кроме того, СКЛиД успешно используют и аниматоры, чтобы наделять нарисованных мультяшных персонажей понятными зрителям эмоциями.

Технологии тотального видеонаблюдения уже стали привычными не только в странах Запада, но и в России, и на очереди массовое внедрение слежки на новом уровне, включающем в себя автоматическое распознавание лиц. И это происходит как раз в тот момент, когда наблюдается настоящий прорыв в области систем распознавания эмоций. Причём, все эти новейшие технологии уже готовы выйти за пределы научных лабораторий и попасть на свобоный рынок, а это означает, что их применения можно ожидать в самых неожиданных сферах и ситуациях.

Коллектив учёных из Калифорнийского университета в Сан-Диего организовал компанию Emotient, основным направлением деятельности которой было объявлено создание программного обеспечения для распознавания и анализа человеческих эмоций. В Emotient делают ставку на машинно-обучаемые алгоритмы обнаружения эмоций. Сейчас в фирме заняты разработкой специального приложения для Google Glass, которое должно появиться на рынке в ближайшее время. Главной функцией этого приложения будет считывание в реальном времени эмоционального состояния людей, которые появляются в поле зрения владельца очков. Сейчас программа проходит стадию испытаний, но она уже без проблем распознаёт счастье, печаль, гнев, отвращение и даже презрение.

После выхода на рынок это приложение будет доступно для скачивания всем владельцам Google Glass, при этом, несмотря на высокую цену, число обладателей этих очков, по некоторым оценкам, может достигать уже 300 тысяч человек. Между тем, другое приложение, разрабатываемое в недрах Emotient для Google Glass, призвано на основе анализа данных о мимике лица отличать истинные эмоциональные реакции от притворных. Иными словами, оно сможет определить, врёт ли вам тот, на кого вы смотрите.

Работа этого приложения построена на теории, согласно которой при выражении подлинных и фальшивых эмоций задействуются разные зоны головного мозга. Если настоящие чувства формируются в головном и спинном мозге на уровне рефлексов, то для демонстрации притворных необходима мыслительная деятельность, что требует работы двигательной зоны коры головного мозга. В результате мельчайшие особенности лицевой мимики для настоящих и симулируемых эоций будут различными, и эти отличия будут достаточно заметны для автоматической фиксации и распознавания техническими средствами. Иными словами, мы получим то, на что способны очень немногие из обычных людей — с высоким уровнем достоверности отличать правду от лжи.

В ходе испытаний системы она смогла распознать в реальном времени 20 из 46 мимических движений, описанных в СКЛиД. И, что куда более интересно, она определила истинность или притворность эмоциональных реакций с точностью 85%. Конечно, тесты проводились в лабораторных условиях, где нетрудно обеспечить идеальные визуальные параметры, однако возможности живого человека в любом случае намного ниже: он способен отличать притворство от естественных реакций с точностью порядка 55%, то есть всего чуть больше, чем в половине случаев.

Да, в Emotient построили детектор лжи на основе технологии распознавания лиц. И он способен с высокой степенью точности ловить на лжи всех, кто попытается сымитировать эмоции или чувства. Распознавание лиц плавно переходит в распознавание эмоций, причём, как показывают тесты, компьютеры гораздо эффективнее в этом, чем живые люди.

Всё это звучит и выглядит впечатляюще, если бы не одно «но»: социальных последствий массового внедрения таких технологий никто из их создателей не просчитывал. И это вовсе не тот случай, когда технология может иметь два применения, как, например, технология деления ядра атома, которая, с одной стороны, позволяет создавать источники дешёвой электроэнергии, а с другой, может лечь в основу смертоносного оружия сокрушительной силы. Автоматическое распознавание подлинности эмоций — это деструктивная технология, направленная исключительно на разоблачение.

Представьте себе недалёкое будущее, когда каждый сможет купить себе специальные очки, способные не только распознавать лица и голоса, но и отличать правду от лжи. Это же настоящая революция в человеческих отношениях! И одновременно мощнейшее вторжение в автономию каждой личности, по сравнению с которым вмешательство в личную жизнь и незаконное распространение персональных данных покажутся детскими забавами.

На уровне общественного поведения, «маленькая невинная ложь», или по научному, «белая ложь» или «ложь хорошего тона», это фундаментальный институт сосуществования и выживания в социуме. К примеру, когда вы говорите «какой милый ребёнок», а на самом деле вы думаете, что он на редкость уродлив, или когда нахваливаете еду, в действительности считая её помоями, это своего рода обман во имя обманутого: если вы соврёте, то собеседнику будет приятно, а если ложь раскроется, то это не повлечёт серьёзных последствий.

Между тем, за «белой ложью» скрывается важнейшее социальное соглашение, общественная игра. В большинстве случаев у лжеца самые лучшие намерения, он просто хочет выглядеть в глазах окружающих вежливым, тактичным или просто милым. Поэтому мы говорим «надо как-нибудь вместе пообедать» человеку, которого хотим больше никогда в жизни не встречать или хвалим платье, которое мы сами не надели бы даже для ремонта автомобиля.

На личном уровне свобода не говорить собеседнику правду — это наше исключительное право как человеческого существа. И то, чего нас лишает новая технология, это не просто невозможность солгать и не быть пойманным. Это угроза нашему праву на частную жизнь, на индивидуальность, личность, угроза праву на выражение своего мнения, которое не сводится исключительно к тому, что мы говорим, но и охватывает то, что мы предпочитаем держать при себе. Создавая техническую возможность сопоставлять то, что мы говорим и как мы выражаем себя, с тем, что мы думаем и ощущаем, мы вторгаемся в наиболее личные для каждого человека вещи: мысли и ощущения.

Технологии наблюдения тоже перейдут на принципиально новый уровень — от наблюдения за действиями и распознавания лиц к оценке эмоций. Личность становится ещё более беззащитной перед властями, работодателями, маркетологами и вообще всем, с кем она взаимодействует. Неизбежно появится множество средств контроля, не только нарушающих тайну действий в личной жизни, но и тайну мыслей и чувств.

К чему может привести постоянное наблюдение за нашими эмоциональными реакциями? К изменению способов самоподачи и того образа, который мы представляем окружающим. Иными словами, стирание грани между мыслью и её выражением неминуемо повлияет на нашу личность.

Если мы не сможем думать одно, а говорить другое, наша личность станет одноцветной и потеряет значительную часть своей глубины. Будучи вынужденными всегда говорить и выражать только то, что мы думаем и чувствуем, под угрозой прослыть лжецами, мы утратим возможность создавать разное впечатление о себе у людей, с которыми мы взаимодействуем. К примеру, мы не сможем прятать какие-то неприглядные стороны своей личности или, напротив, преувеличивать свои сильные и привлекательные качества.

Последствия этого могут быть катастрофическими. Достаточно представить, как будет выглядеть в таком мире собеседование при приёме на работу или первое свидание. Делая нас абсолютно прозрачными для всех остальных, новая технология сама будет формировать наши личности, поскольку мы не сможем надевать разные маски, играть разные роли, подстраиваться под различные условия. Наша личность будет порабощена постоянным давлением окружающих, внимательно вглядывающихся в наши мысли и чувства.

В основе современной цивилизации лежит общество, построенное на ценностях правды и открытости, однако нужно понимать, что слишком много правды и открытости приведут к его краху. Должно оставаться какое-то пространство для лжи, пространство, где человек сможет жить с его собственной правдой и не открывать её никому. В противном случае общество станет попросту непригодным для обитания. Постоянное противостояние с легко проверяемой правдой превратит нас в сверхосторожные, подозрительные и, в целом, довольно мерзкие твари. Всё, что мы говорим и делаем, будет зависеть не от личных предпочтений, интуиции или убеждений, а от сложных расчётов по заданным алгоритмам: в каком месте понизить голос, в какую сторону отвести глаза или когда наморщить лоб. Это будет общество человекомеханизмов с механической «правдой».

Об это стоит задуматься сейчас, ведь мы уже сегодня сталкиваемся с технологиями, заставляющими нас шаг за шагом избавляться от человеческих черт и вести себя в соответствии с некими алгоритмами, которые уже наблюдают за нами и уже судят нас.

Для человека, живущего среди себе подобных, распознавание эмоций — это навык, приобретаемый естественным образом: мы неосознанно определяем, если кто-то злится, расстроен или счастлив по мельчайшим признакам, от еле заметного кивания до почёсывания носа. Многие из нас действительно прекрасно считывают мимику и правильно соотносят её с эмоциональным состоянием человека.

Что же произойдёт, когда компьютеры столь же преуспеют в отслеживании эмоций? Последние достижения в технологии распознавания лиц дают ясное представление о том, во что может превратиться, например, следующее поколение Google Glass. Такие очки смогут «на лету» определять противоречия между тем, что говорит ваш собеседник вербально, то есть вслух, и тем, что он говорит невербально, то есть мимикой лица. При этом проведённые опыты доказывают, что эта технология намного эффективнее человеческих возможностей распознавания подобных нюансов.

Длительное время считалось, что человек способен определять шесть основных эмоциональных состояний: счастье, печаль, страх, гнев, удивление и отвращение. Однако в марте 2014 года учёные из Университета Огайо выяснили, что на самом деле люди могут распознавать 21 выражение лица и соответствующие им эмоциональные состояния, включая такие, как «счастливое удивление» или «яростный страх».

Учёные всегда полагали, что люди намного лучше машин справляются с задачами обработки сенсорных ощущений, включая узнавание голоса и определения выражений лица. Однако получается, что это не так: с ростом производительности компьютеров и совершенства программного обеспечения, машины становятся намного эффективнее. При помощи ПО, разработанного в Университете Огайо, удалось добиться 96,9-процентной точности при распознавании базовых шести эмоций по выражению лица и 76,9-процентной точности при определении сложных эмоциональных состояний. В общем, от компьютера теперь не скрыть наших эмоций.

Алгоритмы, на которых основаны подобные программы распознавания эмоций, разработаны на базе так называемой FACS (Facial Action Coding System) или СКЛиД — «Системы кодирования лицевых движений», созданной ещё в 1978 году Полом Экманом и Уоллесом Фризеном, экспертами по микровыражениям лица. СКЛиД соотносит эмоции с их физическим выражением в мимике лица. Проще говоря, она сводит эмоциональные состояния к их проявлению в определённых наборах мышечных реакций и движений — расширению глаз, поднятию щёк, опусканию уголков губ.

СКЛиД давно используется не только в науке, где она помогает установить связи между эмоциями и процессами, протекающими в мозне человека, но и в медицине, где она применяется для диагностики психических заболеваний вроде аутизма или пост-травматического синдрома, для которых характерны минимальные внешние проявления эмоционального состояния. Кроме того, СКЛиД успешно используют и аниматоры, чтобы наделять нарисованных мультяшных персонажей понятными зрителям эмоциями.

Технологии тотального видеонаблюдения уже стали привычными не только в странах Запада, но и в России, и на очереди массовое внедрение слежки на новом уровне, включающем в себя автоматическое распознавание лиц. И это происходит как раз в тот момент, когда наблюдается настоящий прорыв в области систем распознавания эмоций. Причём, все эти новейшие технологии уже готовы выйти за пределы научных лабораторий и попасть на свобоный рынок, а это означает, что их применения можно ожидать в самых неожиданных сферах и ситуациях.

Коллектив учёных из Калифорнийского университета в Сан-Диего организовал компанию Emotient, основным направлением деятельности которой было объявлено создание программного обеспечения для распознавания и анализа человеческих эмоций. В Emotient делают ставку на машинно-обучаемые алгоритмы обнаружения эмоций. Сейчас в фирме заняты разработкой специального приложения для Google Glass, которое должно появиться на рынке в ближайшее время. Главной функцией этого приложения будет считывание в реальном времени эмоционального состояния людей, которые появляются в поле зрения владельца очков. Сейчас программа проходит стадию испытаний, но она уже без проблем распознаёт счастье, печаль, гнев, отвращение и даже презрение.

После выхода на рынок это приложение будет доступно для скачивания всем владельцам Google Glass, при этом, несмотря на высокую цену, число обладателей этих очков, по некоторым оценкам, может достигать уже 300 тысяч человек. Между тем, другое приложение, разрабатываемое в недрах Emotient для Google Glass, призвано на основе анализа данных о мимике лица отличать истинные эмоциональные реакции от притворных. Иными словами, оно сможет определить, врёт ли вам тот, на кого вы смотрите.

Работа этого приложения построена на теории, согласно которой при выражении подлинных и фальшивых эмоций задействуются разные зоны головного мозга. Если настоящие чувства формируются в головном и спинном мозге на уровне рефлексов, то для демонстрации притворных необходима мыслительная деятельность, что требует работы двигательной зоны коры головного мозга. В результате мельчайшие особенности лицевой мимики для настоящих и симулируемых эоций будут различными, и эти отличия будут достаточно заметны для автоматической фиксации и распознавания техническими средствами. Иными словами, мы получим то, на что способны очень немногие из обычных людей — с высоким уровнем достоверности отличать правду от лжи.

В ходе испытаний системы она смогла распознать в реальном времени 20 из 46 мимических движений, описанных в СКЛиД. И, что куда более интересно, она определила истинность или притворность эмоциональных реакций с точностью 85%. Конечно, тесты проводились в лабораторных условиях, где нетрудно обеспечить идеальные визуальные параметры, однако возможности живого человека в любом случае намного ниже: он способен отличать притворство от естественных реакций с точностью порядка 55%, то есть всего чуть больше, чем в половине случаев.

Да, в Emotient построили детектор лжи на основе технологии распознавания лиц. И он способен с высокой степенью точности ловить на лжи всех, кто попытается сымитировать эмоции или чувства. Распознавание лиц плавно переходит в распознавание эмоций, причём, как показывают тесты, компьютеры гораздо эффективнее в этом, чем живые люди.

Всё это звучит и выглядит впечатляюще, если бы не одно «но»: социальных последствий массового внедрения таких технологий никто из их создателей не просчитывал. И это вовсе не тот случай, когда технология может иметь два применения, как, например, технология деления ядра атома, которая, с одной стороны, позволяет создавать источники дешёвой электроэнергии, а с другой, может лечь в основу смертоносного оружия сокрушительной силы. Автоматическое распознавание подлинности эмоций — это деструктивная технология, направленная исключительно на разоблачение.

Представьте себе недалёкое будущее, когда каждый сможет купить себе специальные очки, способные не только распознавать лица и голоса, но и отличать правду от лжи. Это же настоящая революция в человеческих отношениях! И одновременно мощнейшее вторжение в автономию каждой личности, по сравнению с которым вмешательство в личную жизнь и незаконное распространение персональных данных покажутся детскими забавами.

На уровне общественного поведения, «маленькая невинная ложь», или по научному, «белая ложь» или «ложь хорошего тона», это фундаментальный институт сосуществования и выживания в социуме. К примеру, когда вы говорите «какой милый ребёнок», а на самом деле вы думаете, что он на редкость уродлив, или когда нахваливаете еду, в действительности считая её помоями, это своего рода обман во имя обманутого: если вы соврёте, то собеседнику будет приятно, а если ложь раскроется, то это не повлечёт серьёзных последствий.

Между тем, за «белой ложью» скрывается важнейшее социальное соглашение, общественная игра. В большинстве случаев у лжеца самые лучшие намерения, он просто хочет выглядеть в глазах окружающих вежливым, тактичным или просто милым. Поэтому мы говорим «надо как-нибудь вместе пообедать» человеку, которого хотим больше никогда в жизни не встречать или хвалим платье, которое мы сами не надели бы даже для ремонта автомобиля.

На личном уровне свобода не говорить собеседнику правду — это наше исключительное право как человеческого существа. И то, чего нас лишает новая технология, это не просто невозможность солгать и не быть пойманным. Это угроза нашему праву на частную жизнь, на индивидуальность, личность, угроза праву на выражение своего мнения, которое не сводится исключительно к тому, что мы говорим, но и охватывает то, что мы предпочитаем держать при себе. Создавая техническую возможность сопоставлять то, что мы говорим и как мы выражаем себя, с тем, что мы думаем и ощущаем, мы вторгаемся в наиболее личные для каждого человека вещи: мысли и ощущения.

Технологии наблюдения тоже перейдут на принципиально новый уровень — от наблюдения за действиями и распознавания лиц к оценке эмоций. Личность становится ещё более беззащитной перед властями, работодателями, маркетологами и вообще всем, с кем она взаимодействует. Неизбежно появится множество средств контроля, не только нарушающих тайну действий в личной жизни, но и тайну мыслей и чувств.

К чему может привести постоянное наблюдение за нашими эмоциональными реакциями? К изменению способов самоподачи и того образа, который мы представляем окружающим. Иными словами, стирание грани между мыслью и её выражением неминуемо повлияет на нашу личность.

Если мы не сможем думать одно, а говорить другое, наша личность станет одноцветной и потеряет значительную часть своей глубины. Будучи вынужденными всегда говорить и выражать только то, что мы думаем и чувствуем, под угрозой прослыть лжецами, мы утратим возможность создавать разное впечатление о себе у людей, с которыми мы взаимодействуем. К примеру, мы не сможем прятать какие-то неприглядные стороны своей личности или, напротив, преувеличивать свои сильные и привлекательные качества.

Последствия этого могут быть катастрофическими. Достаточно представить, как будет выглядеть в таком мире собеседование при приёме на работу или первое свидание. Делая нас абсолютно прозрачными для всех остальных, новая технология сама будет формировать наши личности, поскольку мы не сможем надевать разные маски, играть разные роли, подстраиваться под различные условия. Наша личность будет порабощена постоянным давлением окружающих, внимательно вглядывающихся в наши мысли и чувства.

В основе современной цивилизации лежит общество, построенное на ценностях правды и открытости, однако нужно понимать, что слишком много правды и открытости приведут к его краху. Должно оставаться какое-то пространство для лжи, пространство, где человек сможет жить с его собственной правдой и не открывать её никому. В противном случае общество станет попросту непригодным для обитания. Постоянное противостояние с легко проверяемой правдой превратит нас в сверхосторожные, подозрительные и, в целом, довольно мерзкие твари. Всё, что мы говорим и делаем, будет зависеть не от личных предпочтений, интуиции или убеждений, а от сложных расчётов по заданным алгоритмам: в каком месте понизить голос, в какую сторону отвести глаза или когда наморщить лоб. Это будет общество человекомеханизмов с механической «правдой».

Об это стоит задуматься сейчас, ведь мы уже сегодня сталкиваемся с технологиями, заставляющими нас шаг за шагом избавляться от человеческих черт и вести себя в соответствии с некими алгоритмами, которые уже наблюдают за нами и уже судят нас.

Комментарии 4

|

0

Alexei2012

28.07.2014 13:26

[Материал]

«Умиление» и восхищение «умными» машинами закончится в тот момент, когда станет ясно, что эти «синтетики» могут заменить человека ВЕЗДЕ. А обычные «органики» в общем то и не к чему … «Умиление» и восхищение «умными» машинами закончится в тот момент, когда станет ясно, что эти «синтетики» могут заменить человека ВЕЗДЕ. А обычные «органики» в общем то и не к чему … http://www.dailymotion.com/video/xtzbo2_transhumanism-vs-humanism_tech |