Вход / Регистрация

22.02.2026, 01:50

/ Новости сайта / Наука и Технологии / Искусственный интеллект Amazon обвинили в предвзятости к расе человека

Искусственный интеллект Amazon обвинили в предвзятости к расе человека

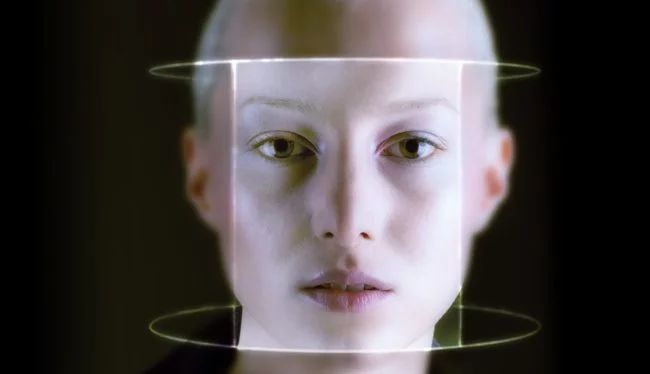

Разработкой системы распознавания лиц занимается практически каждая технологическая компания. Одной из них является Amazon — ее технология называется Rekognition и, по мнению специалистов из Массачусетского технологического института, она сильно уступает своим аналогам. Дело в том, что в ходе оценки ее точности выяснилось, что система часто не может различить пол чернокожих людей. Это уже вторая жалоба на оскорбительную работу распознавания лиц Amazon.

Ученые проверяли работу искусственного интеллекта Rekognition на протяжении всего 2018 года. Количество ошибок при определении пола чернокожих людей достигало 31% и это, по мнению исследователей, ужасный результат. Для сравнения, распознавание лиц Microsoft допускает подобные ошибки только в 1,5% случаев.

Компания Amazon считает, что претензии исследователей лишены оснований. Она уверила, что во внутренних тестах обновленной версии Rekognition не было замечено ни одной шибки. Исследователи обратили внимание, что сотрудники MIT не назвали уровень точности, при достижении которой работа искусственного интеллекта Amazon считалась бы «правильной».

По словам генерального директора по глубокому обучению Amazon Web Services Мэтта Вуда, они самостоятельно проверили систему, используя миллион изображений лиц из базы данных Megaface. В ходе их тестирования искусственный интеллект не допустил ни единой ошибки. При этом представитель компании объявил, что они готовы прислушиваться к результатам сторонних тестов для того, чтобы улучшить свой продукт.

Это далеко не первый случай, когда искусственный интеллект Amazon оказался в центре скандала. Летом 2018 года она приняла 28 членов Конгресса за преступников, причем 38% из них были чернокожими.

С подобными скандалами имели дело и другие компании. К счастью, они извлекают уроки из ситуаций и постоянно улучшают технологии. В июне Microsoft расширила количество данных, используемых при распознавании лиц — в частности, система начала больше обращать внимание на пол, возраст и оттенок кожи. Это уменьшило количество ошибок при сортировке мужчин и женщин до 20 раз.

Ученые проверяли работу искусственного интеллекта Rekognition на протяжении всего 2018 года. Количество ошибок при определении пола чернокожих людей достигало 31% и это, по мнению исследователей, ужасный результат. Для сравнения, распознавание лиц Microsoft допускает подобные ошибки только в 1,5% случаев.

Компания Amazon считает, что претензии исследователей лишены оснований. Она уверила, что во внутренних тестах обновленной версии Rekognition не было замечено ни одной шибки. Исследователи обратили внимание, что сотрудники MIT не назвали уровень точности, при достижении которой работа искусственного интеллекта Amazon считалась бы «правильной».

По словам генерального директора по глубокому обучению Amazon Web Services Мэтта Вуда, они самостоятельно проверили систему, используя миллион изображений лиц из базы данных Megaface. В ходе их тестирования искусственный интеллект не допустил ни единой ошибки. При этом представитель компании объявил, что они готовы прислушиваться к результатам сторонних тестов для того, чтобы улучшить свой продукт.

Это далеко не первый случай, когда искусственный интеллект Amazon оказался в центре скандала. Летом 2018 года она приняла 28 членов Конгресса за преступников, причем 38% из них были чернокожими.

С подобными скандалами имели дело и другие компании. К счастью, они извлекают уроки из ситуаций и постоянно улучшают технологии. В июне Microsoft расширила количество данных, используемых при распознавании лиц — в частности, система начала больше обращать внимание на пол, возраст и оттенок кожи. Это уменьшило количество ошибок при сортировке мужчин и женщин до 20 раз.

Источник: https://hi-news.ru

Комментарии 4

|

|

0

KoshkaHavroshka

26.01.2019 18:07

[Материал]

На самом деле все довольно просто и предвзятость к расе совсем тут не причем. Чернокожие люди вообще плохо определяются фототехникой, потому что слишком большой контраст между цветом их кожи и окружающей среды, техника видит это всё как чёрный силуэт на ярком фоне и довольно сложно определить там не то что пол, даже детали лица порой совсем не видны. Это довольно известная проблема в кругах фотографов и видеографов.

|

|

0

Voskresenski

26.01.2019 22:57

[Материал]

А как же тотальная система распознавания лиц, она тоже на них "глючит"?

|

|

|

0

KoshkaHavroshka

07.02.2019 18:59

[Материал]

В большинстве случаев да, глючит. Почитайте статьи на эту тему, там система даже порой не может отличить чернокожих мужское лицо от женского. Об этом особенно не распространяются и не выставляют на показ эти данные, чтоб не разжигать, но проблема от этого меньше не становится))

|

|

+2

Alexei2012

26.01.2019 16:32

[Материал]

Мне этот случай почему-то напомнил старинный анекдот аж 19-го века может и не анекдот, а притча. Полиция поймала попугая, который повторял Император дурак и арестовали его хозяина, а тот утверждал, что никак не поддерживает взгляды попугая и с ними не согласен.. Мне этот случай почему-то напомнил старинный анекдот аж 19-го века может и не анекдот, а притча. Полиция поймала попугая, который повторял Император дурак и арестовали его хозяина, а тот утверждал, что никак не поддерживает взгляды попугая и с ними не согласен.. |