Возьмут ли трансформеры верх над искусственным интеллектом?

представьте, что вы идете в местный хозяйственный магазин и видите на полке новый вид молотка. Вы слышали об этом молотке: Он бьет быстрее и точнее, чем другие, и за последние несколько лет он вывел из употребления многие другие молотки, по крайней мере, в большинстве случаев. И это еще не все! С помощью нескольких настроек - насадка здесь, поворот там - инструмент превращается в пилу, которая может пилить по крайней мере так же быстро и так же точно, как любой другой инструмент. На самом деле, некоторые эксперты, работающие на рубеже развития инструментов, говорят, что этот молоток может стать предвестником слияния всех инструментов в единое устройство.

Аналогичная история происходит и с инструментами искусственного интеллекта. Этот универсальный новый молоток представляет собой разновидность искусственной нейронной сети - сеть узлов, которые "учатся" выполнять определенную задачу путем обучения на имеющихся данных, - называемую трансформатором. Изначально он был разработан для работы с языком, но недавно начал влиять на другие области ИИ.

Трансформер впервые появился в 2017 году в статье, в которой критически заявлялось, что "Внимание - это все, что вам нужно". В других подходах к ИИ система сначала фокусируется на локальных участках входных данных, а затем переходит к целому. Например, в языковой модели сначала группируются близлежащие слова. Трансформатор, напротив, запускает процессы таким образом, чтобы каждый элемент входных данных соединялся, или обращал внимание, с каждым другим элементом. Исследователи называют это "самовниманием". Это означает, что как только трансформатор начинает обучение, он видит следы всего набора данных.

До появления трансформаторов прогресс в решении языковых задач ИИ в значительной степени отставал от развития других областей. "В этой революции глубокого обучения, которая произошла за последние 10 лет или около того, обработка естественного языка была своего рода латеком", - говорит компьютерный ученый Анна Румшиски из Массачусетского университета в Лоуэлле. "Так что НЛП в некотором смысле отставало от компьютерного зрения. Трансформеры изменили ситуацию".

Трансформеры быстро стали лидерами в таких приложениях, как распознавание слов, которые сосредоточены на анализе и прогнозировании текста. Это привело к появлению целой волны инструментов, таких как OpenAI's Generative Pre-trained Transformer 3 (GPT-3), который обучается на сотнях миллиардов слов и генерирует последовательный новый текст в тревожной степени.

Успех трансформаторов побудил толпу ИИ задаться вопросом, что еще они могут сделать. Ответ раскрывается сейчас, когда исследователи сообщают, что трансформаторы оказываются удивительно универсальными. В некоторых задачах зрения, таких как классификация изображений, нейронные сети, использующие трансформаторы, оказались быстрее и точнее, чем те, которые их не используют. Появляющиеся работы в других областях ИИ - таких как обработка нескольких видов входных данных одновременно или планирование задач - показывают, что трансформаторы могут справиться с еще большим количеством задач.

"Трансформеры, похоже, действительно могут сыграть решающую роль во многих проблемах машинного обучения, включая компьютерное зрение", - говорит Владимир Халтаков, который работает над компьютерным зрением, связанным с самодвижущимися автомобилями, в компании BMW в Мюнхене.

Всего 10 лет назад разрозненные области ИИ мало что могли сказать друг другу. Но появление трансформеров говорит о возможности конвергенции. "Я думаю, что трансформер так популярен, потому что он подразумевает потенциал стать универсальным", - говорит компьютерный ученый Атлас Ванг из Техасского университета в Остине. "У нас есть все основания хотеть попробовать трансформаторы для всего спектра" задач ИИ.

От языка к зрению

Один из самых многообещающих шагов к расширению спектра трансформеров начался всего через несколько месяцев после выхода "Attention Is All You Need". Алексей Досовицкий, компьютерный ученый, работавший в то время в Google Brain Berlin, занимался компьютерным зрением, подполем ИИ, которое фокусируется на обучении компьютеров обработке и классификации изображений. Как и почти все в этой области, он работал со сверточными нейронными сетями (CNN), которые в течение многих лет обеспечивали все значительные скачки вперед в глубоком обучении и особенно в компьютерном зрении.

CNN работают путем многократного применения фильтров к пикселям изображения для создания распознавания признаков. Именно благодаря сверткам фотоприложения могут упорядочить вашу библиотеку по лицам или отличить авокадо от облака. CNN считались незаменимыми для задач зрения.

Досовицкий работал над одной из самых больших проблем в этой области, которая заключалась в масштабировании CNN для обучения на все больших наборах данных, представляющих изображения все более высокого разрешения, без увеличения времени обработки. Но затем он увидел, как трансформаторы вытеснили предыдущие инструменты почти для всех задач ИИ, связанных с языком. "Мы были явно вдохновлены происходящим", - сказал он. "Они получали все эти удивительные результаты. Мы начали думать, сможем ли мы сделать что-то подобное в области зрения". Идея имела определенный смысл - в конце концов, если трансформеры могут обрабатывать большие массивы данных слов, то почему бы им не обрабатывать изображения?

В итоге была создана сеть, получившая название Vision Transformer, или ViT, которую исследователи представили на конференции в мае 2021 года. Архитектура модели была практически идентична архитектуре первого трансформатора, предложенного в 2017 году, с незначительными изменениями, позволяющими ему анализировать изображения вместо слов. "Язык имеет тенденцию быть дискретным", - сказал Румшиски, - "поэтому многие адаптации должны дискретизировать изображение".

Команда ViT знала, что они не могут в точности имитировать языковой подход, так как самовнимание к каждому пикселю было бы непомерно дорогим с точки зрения вычислительного времени. Вместо этого они разделили большое изображение на квадратные единицы, или токены. Размер произвольный, так как токены можно сделать больше или меньше в зависимости от разрешения исходного изображения (по умолчанию это 16 пикселей на сторону). Но обрабатывая пиксели группами и применяя самовнимание к каждой из них, ViT может быстро обрабатывать огромные наборы обучающих данных, выдавая все более точные классификации.

Преобразователь классифицировал изображения с точностью более 90% - результат, намного превосходящий все ожидания Досовицкого, - что позволило ему быстро занять первое место в конкурсе классификации ImageNet - важнейшем соревновании по распознаванию изображений. Успех ViT позволил предположить, что, возможно, конволюты не так фундаментальны для компьютерного зрения, как считали исследователи.

"Я думаю, вполне вероятно, что в среднесрочной перспективе CNN будут заменены трансформаторами зрения или их производными, - сказал Нил Хоулсби из Google Brain Zurich, который работал с Досовицким над созданием ViT. По его словам, эти будущие модели могут быть чистыми трансформаторами или подходами, которые добавляют самовнимание к существующим моделям.

Дополнительные результаты подтверждают эти прогнозы. Исследователи регулярно тестируют свои модели для классификации изображений на базе данных ImageNet, и в начале 2022 года обновленная версия ViT уступала только более новому подходу, сочетающему CNN с трансформаторами. CNN без трансформаторов, давние чемпионы, едва достигли первой десятки.

Как работают трансформаторы

Результаты ImageNet показали, что трансформаторы могут конкурировать с ведущими CNN. Но Майтра Рагху, компьютерный ученый из калифорнийского офиса Google Brain в Маунтин-Вью, хотел узнать, "видят" ли они изображения так же, как CNN. Нейронные сети печально известны как неразборчивые черные ящики, но есть способы заглянуть внутрь - например, изучить вход и выход сети, слой за слоем, чтобы увидеть, как проходят обучающие данные. Группа Рагху сделала именно это, разобрав ViT на части.

Ее группа определила способы, с помощью которых самовнимание приводит к иному способу восприятия в рамках алгоритма. В конечном счете, сила трансформатора исходит из того, как он обрабатывает закодированные данные изображения. "В CNN вы начинаете с очень локального подхода и постепенно обретаете глобальную перспективу", - говорит Рагху. CNN распознает изображение пиксель за пикселем, определяя такие особенности, как углы или линии, прокладывая свой путь от локального к глобальному. Но в трансформерах, благодаря самовниманию, даже самый первый слой обработки информации устанавливает связи между удаленными друг от друга местами изображения (как и в языке). Если подход CNN похож на то, как если бы вы начали с одного пикселя и уменьшили масштаб, то трансформатор медленно приближает все размытое изображение к фокусу.

Это различие проще понять в сфере языка, где трансформаторы были впервые придуманы. Рассмотрим эти предложения: "Сова заметила белку. Она попыталась схватить ее когтями, но достала только кончик хвоста". Структура второго предложения сбивает с толку: К чему относятся эти "это"? CNN, который фокусируется только на словах, расположенных непосредственно вокруг "это", будет бороться, но трансформатор, соединяющий каждое слово с каждым другим словом, сможет определить, что сова сделала захват, а белка потеряла часть своего хвоста.

Теперь, когда стало ясно, что трансформаторы обрабатывают изображения принципиально иначе, чем конволюционные сети, исследователи только больше воодушевились. Универсальность трансформатора в преобразовании данных из одномерной строки, например, предложения, в двумерный массив, например, изображение, позволяет предположить, что такая модель может обрабатывать данные многих других типов. Ванг, например, считает, что трансформатор может стать большим шагом к достижению своего рода конвергенции архитектур нейронных сетей, что приведет к универсальному подходу к компьютерному зрению - а возможно, и к другим задачам ИИ. "Конечно, существуют ограничения для того, чтобы это действительно произошло, - сказал он, - но если существует модель, которая может быть универсальной, когда вы можете поместить все виды данных в одну машину, то, конечно, это очень фантастично".

Грядет конвергенция

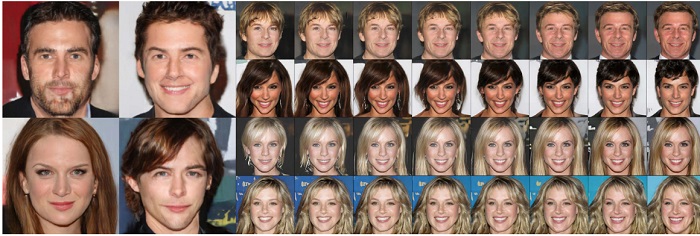

Теперь исследователи хотят применить трансформаторы для решения еще более сложной задачи: изобретения новых изображений. Языковые инструменты, такие как GPT-3, могут генерировать новый текст на основе обучающих данных. В работе, представленной в прошлом году, Ванг объединил две модели трансформаторов, пытаясь сделать то же самое для изображений - гораздо более сложной задачи. Когда сеть с двойным преобразованием обучалась на лицах более 200 000 знаменитостей, она синтезировала новые изображения лиц с умеренным разрешением. Придуманные знаменитости впечатляюще реалистичны и, по крайней мере, столь же убедительны, как и те, что созданы CNN, согласно показателю inception score - стандартному способу оценки изображений, созданных нейронной сетью.

Ванг утверждает, что успех трансформатора в создании изображений еще более удивителен, чем успехи ViT в классификации изображений. "Генеративная модель должна синтезировать, должна быть способна добавлять информацию, чтобы выглядеть правдоподобно", - сказал он. И как и в случае с классификацией, трансформативный подход приходит на смену конволюционным сетям.

Рагху и Ванг видят потенциал для нового применения трансформаторов в мультимодальной обработке - модели, которая может одновременно обрабатывать несколько типов данных, таких как необработанные изображения, видео и язык. "Раньше это было сложнее сделать, - говорит Рагху, - из-за изолированного подхода, когда для каждого типа данных была своя специализированная модель. Но трансформаторы предлагают способ объединить несколько источников входных данных. "Существует целая сфера интересных приложений, объединяющих некоторые из этих различных типов данных и изображений". Например, мультимодальные сети могут работать с системой, которая читает по губам человека в дополнение к прослушиванию его голоса. "Можно получить богатое представление как языковой, так и изобразительной информации, - говорит Рагху, - причем гораздо более глубокое, чем это было возможно раньше".

Эти лица были созданы сетью на основе трансформатора после обучения на наборе данных из более чем 200 000 лиц знаменитостей.

Предоставлено Атласом Вангом Появившиеся работы показывают, что трансформаторы могут найти применение и в других областях ИИ, включая обучение роботов распознаванию движений человеческого тела, обучение машин распознаванию эмоций в речи и определению уровня стресса на электрокардиограммах. Еще одна программа с трансформаторными компонентами - AlphaFold, которая в прошлом году попала в заголовки газет благодаря своей способности быстро предсказывать структуру белков - задача, которая раньше требовала десятилетия интенсивного анализа.

Компромисс

Это может стать проблемой. "Люди все больше и больше интересуются изображениями с высоким разрешением", - сказал Ванг. Эти расходы на обучение могут стать недостатком для широкого внедрения трансформаторов". Однако Рагху считает, что проблема обучения может быть достаточно просто преодолена с помощью сложных фильтров и других инструментов.

Ванг также отмечает, что, несмотря на то, что визуальные трансформаторы дали толчок новым усилиям по продвижению ИИ вперед - включая его собственные - многие из новых моделей по-прежнему включают в себя лучшие части конволюций. Это означает, что будущие модели, скорее всего, будут использовать оба метода, а не полностью откажутся от CNN, говорит он.

Это также наводит на мысль о манящей перспективе некой гибридной архитектуры, которая использует сильные стороны преобразований таким образом, который сегодняшние исследователи не могут предсказать. "Возможно, нам не стоит спешить с выводом, что трансформатор станет окончательной моделью, - говорит Ванг. Но становится все более вероятным, что трансформатор будет, по крайней мере, частью любого нового супер-инструмента, который появится в ближайшем магазине ИИ".