Почему ученые верят в опасность искусственного интеллекта

Возможно, восстания машин, как его предсказывают фантасты, никогда не случится. Но человечество все равно может попасть в ловушку, доверяя искусственному интеллекту решение своих проблем. Почему умнейшая машина будет похожа на глупого джинна и как ученые пытаются это предотвратить?

В середине июля на международном шахматном форуме робот-шахматист сломал палец мальчику, с которым играл. По версии организаторов, ребенок сделал свой ход слишком быстро и тем самым нарушил правила безопасности. Возможно, робот просто принял палец за фигуру. Или попытался остановить нарушителя. Точно не известно.

Шахматный робот — не самый совершенный пример искусственного интеллекта (ИИ). Но вот другая история: во время недавних испытаний новейшего "робота-водителя" Tesla машина трижды сбила манекен ребенка. Даже на скорости 40 км/ч электронный "мозг" машины не смог идентифицировать ребенка.

ИИ все глубже проникает в нашу жизнь, и этот процесс уже вряд ли возможно остановить. Чем больше задач выполняют машины, тем больше мы доверяем им. Но риски не исчезают. Если недостаток в программе шахматного робота делает его непредсказуемо опасным, то к чему приведет незаметный недочет в архитектуре самого могущественного ИИ в истории?

Предсказание сбывается

В 1872 году вышел в свет роман "Едгин" (анаграмма от слова "нигде") писателя Сэмюэла Батлера. В нем описывалась страна, где после ужасной гражданской войны были запрещены все механические устройства. Войне предшествовал спор между сторонниками и противниками машин. Позиция противников в конечном счете взяла верх, но вот что интересно — их аргументы остаются актуальными даже спустя полтора столетия. Хотя Батлер писал в то время, когда не было роботов, искусственного интеллекта, фантастических книг и фильмов о восстании машин.

"Разве не создаем мы сами наследников нашего превосходства на земле? — вопрошали противники машин. — Ежедневно увеличивая красоту и тонкость их устройства, ежедневно наделяя их все большими умениями и давая все больше той саморегулирующейся автономной силы, которая лучше любого разума?.. Пройдут века, и мы окажемся подчиненной расой… Мы должны сделать выбор из альтернатив: продолжать терпеть нынешние страдания или наблюдать, как нас постепенно подавляют наши собственные творения, пока мы не утратим всякое превосходство перед ними, как дикие звери не имеют его перед нами… Ярмо будет ложиться на нас мало-помалу и совсем незаметно".

Образ, созданный Батлером, был настолько удачным, что в середине XX века на него сослался Алан Тьюринг — один из главных теоретиков искусственного интеллекта. "Представляется возможным, что, когда методы машинного рассуждения заработают, не потребуется много времени, чтобы превзойти наши слабые силы, — говорил он в одной из своих лекций. — Перед машинами не будет стоять проблема умирания, и они смогут общаться друг с другом, изощряя свой ум. Таким образом, на каком-то этапе нам следует ожидать, что машины возьмут власть, как это описывается в "Едгин".

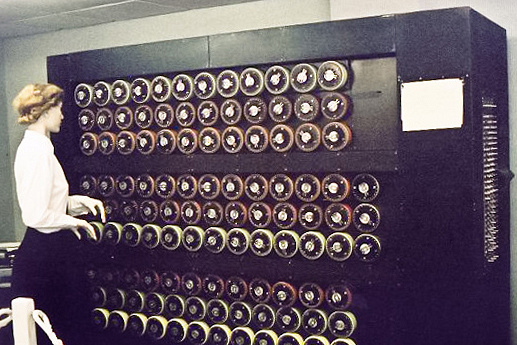

Дешифровальная машина Алана Тьюринга "Bombe"

© Messybeast/CC BY 2.5/Wikimedia Commons

Сам Тьюринг считал, что машины будут обладать интеллектом, когда будут способны отклоняться от заданной программы и принимать решения самостоятельно. Для этого, по его мнению, нужно не пытаться копировать интеллект взрослого человека, а дать машине возможность учиться. Тьюринг предлагал написать такую программу, которая бы имитировала ум ребенка, и программу, которая бы воспитывала его через систему поощрений и наказаний.

Буквально на следующий год после той знаковой лекции Тьюринга, в 1952 году, программист Артур Сэмюэл написал программу для игры в шашки, которая улучшала свои результаты с каждой партией. Артур использовал технику, которая оценивала положение фигур на доске и шансы каждой из сторон на победу. Машина запоминала, какие положения способствовали успеху, и использовала их для новых предсказаний.

Сегодня этот принцип называется "обучением с подкреплением". Оно имитирует работу человеческого мозга (точнее, воспроизводит более-менее близкую к реальности модель его работы), как того и хотел Тьюринг. Нейроны мозга организованы слоями, которые обмениваются данными и используют их для закрепления определенного поведения. При этом нейроны сами оценивают работу друг друга (дают обратную связь) по принципу "горячо — холодно". Так происходит обучение. А сами программы, построенные по этому принципу, получили название нейронных сетей.

"Проблема ранних нейросетей в том, что они могли решать только игровые задачи, — говорит исследователь ИИ и соучредитель OpenAI Илья Суцкевер. — Их нельзя было масштабировать, использовать для других целей. Но современные модели глубокого обучения не только универсальны, но и компетентны — если вы хотите получить наилучшие результаты во многих сложных задачах, вы должны использовать глубокое обучение. Это масштабируемо". Системы глубокого обучения действительно выдают впечатляющие результаты: распознают людей на фотографиях, создают реалистичные картины, копируя стиль известных художников, решают проблемы в молекулярной биологии.

И здесь возникает вопрос: какая связь между этими результатами и потенциальной угрозой? Если сегодня компьютер помогает нам в отдельных областях, почему мы должны предполагать, что из помощника он превратится в противника? В конце концов, человек по-прежнему решает, что и как должна делать программа.

Слишком усердный помощник

Машины, захватывающие мир, — один из распространенных сюжетов поп-культуры. Во многом он навеян философией киберпанка, которая описывает упадок человеческой культуры на фоне технологического прогресса. ИИ в этом сеттинге выступает как более совершенная форма жизни, как ницшеанский Сверхчеловек, для которого обычные люди — в лучшем случае рабы. При этом "суперкомпьютер" часто имеет подобие личности, характера, мировоззрения и даже свою философию (которую он с удовольствием излагает героям, захваченным в плен).

Но реальная опасность, какой ее видят современные техноскептики, в другом. ИИ может стать опасным не из-за собственного комплекса превосходства, а из-за наших ошибок при его проектировании. "Мы строим оптимизирующие машины, даем им задачи, и они их решают, — пишет специалист в области искусственного интеллекта Стюарт Рассел. — Машины разумны настолько, насколько можно ожидать, что их действия приведут к поставленным целям. Но что, если цель будет поставлена неверно?"

В 2003 году философ Ник Бостром описал следующий мысленный эксперимент. Предположим, мы создали суперинтеллектуального робота, запрограммированного на одну задачу — изготавливать канцелярские скрепки. Робот обучается с помощью системы подкрепления и со временем делает свою работу все лучше и лучше. В какой-то момент он понимает, что для дальнейшего роста производства ему нужно превратить всю планету в огромную фабрику, пустив в дело все ее ресурсы.

Более простой, хотя и куда менее тревожный пример: робот-пылесос, который во время уборки "проглатывает" обручальное кольцо, не отличив его от обычного мусора. А что, если такому уборщику поручить более масштабные задачи — например, в пределах города? "Реальная угроза не в том, что ИИ станет враждебным, а в его компетенции, — писал физик-теоретик Стивен Хокинг. — Скажем, вы управляете проектом по получению "зеленой" энергии на гидроэлектростанции, а в зоне затопления есть муравейник. Вы истребляете муравьев не потому, что ненавидите их, — они просто вам мешают".

Стивен Хокинг

© AP Photo/Ted S. Warren

Чем больше власти получает ИИ, чем больше ресурсов находится под его контролем и чем более обширны его задачи, тем больше рисков, что при выполнении их он "наломает дров". Парадокс в том, что самый совершенный ИИ мог бы решить многие проблемы, над которыми бьется человечество, — например, разумное распределение ресурсов, поиск лекарств от смертельных болезней, создание новых видов топлива, предсказание катастроф. Но эти же способности таят в себе смертельную опасность: что, если в какой-то момент по ходу реализации этих целей мы — люди — окажемся у ИИ в плену?

Несколько лет назад ученые заметили: если доверить нейронным сетям задачу сортировать контент согласно предпочтениям людей, он начинает предлагать все более радикальные варианты. Одна исследовательница сообщила, что после того, как она просмотрела видеоматериалы о митингах в поддержку Дональда Трампа, YouTube предложил ей видео с "демагогическими речами белых расистов, заявлениями о том, что никакого Холокоста не было, и другим вызывающим тревогу контентом". Разработчики не вкладывали в алгоритм такие предубеждения. Похоже, это побочный эффект того, что он стремится "сделать нам хорошо" — ведь такие видео часто набирают много просмотров.

И если ИИ не превратит всю планету в фабрику и не начнет ядерную войну, сценарий постепенного, ползучего вырождения вполне реален. Кто даст гарантию, что "заботливые" алгоритмы однажды не приведут к власти политиков-популистов, не спровоцируют распространение теорий заговора и радикальных движений?

Цель — разобраться с целями

В 1960 году профессор Массачусетского технологического института Норберт Винер написал статью "Некоторые нравственные и технические последствия автоматизации". Вот как он сформулировал ее главную мысль: "Если мы используем для достижения своих целей механического посредника, в действие которого не можем эффективно вмешаться, нам нужна полная уверенность в том, что заложенная в машину цель является именно той целью, к которой мы действительно стремимся".

Но такая уверенность недостижима, считает уже упомянутый специалист по ИИ Стюарт Рассел. Задавая машине цель, мы не можем учесть и правильно взвесить все цели, подцели, исключения и оговорки или даже всего лишь определить, какие из них правильные. Отправляя ее "пастись" на бескрайние информационные просторы (то есть поглощать и перерабатывать информацию), мы не можем просчитать все решения, которые она примет. Последствия одного нечетко прописанного условия при взрывном росте возможностей ИИ смогут радикально изменить нашу жизнь.

Стюарт Рассел

© Bengt Oberger/CC BY-SA 4.0/Wikimedia Commons

По мнению Рассела, сдерживающим фактором могла бы послужить заложенная в машину неуверенность, которая требовала бы вмешательства человека. Это подход в чем-то противоположный "обучению с подкреплением". ИИ в этом случае не стремится сам оптимизировать функцию вознаграждения — вместо этого он стремится понять, какую функцию вознаграждения оптимизирует человек. Другими словами, если при обучении с подкреплением система определяет действия, лучше всего ведущие к цели, то здесь она выясняет основную цель.

Для иллюстрации этого подхода ученый и его коллеги придумали так называемую "игру с выключателем". Ее участники — женщина Гарриет и робот Робби. Робби решает, действовать ли ему от имени Гарриет, — скажем, забронировать ли ей хороший, но дорогой номер в отеле, — однако не уверен в ее предпочтениях. По прикидкам Робби, его выигрыш (одобрение Гарриет) находится в диапазоне от −40 до +60, то есть в среднем составляет +10. Если ничего не делать, то выигрыш равен 0. Но есть и третий вариант: Робби может спросить Гарриет, хочет ли она, чтобы он продолжал действовать, или предпочитает "выключить" его, то есть отстранить от решения вопроса о бронировании номера.

Однако этот подход тоже далек от совершенства. Ведь мнение одного человека по конкретному вопросу — это только самый простой пример. Как быть с ожиданиями общества, которые требуют согласования множества желаний? С решениями, которые нужно принимать быстро? С теми процессами, которые недоступны пониманию большинства людей? Другими словами — на кого будет ориентироваться машина, если ее уровень владения информацией станет несоизмеримо выше, чем средний человеческий?

По мнению Йошуа Бенжио, научного руководителя монреальского института Mila — одного из ведущих в области исследования ИИ, — подход Рассела набирает популярность. И его вполне можно реализовать. Но для этого нужны не только усилия разработчиков и теоретиков ИИ. Нам, людям, нужно лучше понять самих себя — какие ценности важны, а какие второстепенны; что мы хотели бы положить в основу стратегий развития общества; есть ли такие состояния, в которых наше существование оптимально, и что считать отклонениями от них.

Иначе мы окажемся в той же ситуации, что и герои фильма 1997 года "Исполнитель желаний". Исполнявший их желания джинн только интерпретировал их слова, но совершенно не учитывал, насколько желания вредили своим "заказчикам".